Als ich einem Freund schrieb, meine KI hätte seine Handschrift lesen können, fragt er ob „KI“, „kluge Irene“ heißt, da meine Frau auch so gut wie jede Ärzteschrift lesen kann.. Und ja, eine solche KI macht viel Sinn. Aber ich hatte eigentlich Chat-GPTs multimodale Lesefähigkeit loben wollen.

Das Bild geht ins Netz, wird gelesen und zurück kommt eine ganz brauchbare Beschreibung des innhalts. Ein Vorgang den man schon fast gewohnt ist. Bei der Gelegenheit kann man gleich mal etwas übersetzen lassen, oder Texte zur eigenen Verwendung in einem anderen „Ton“ umformulieren lassen. Und bei den großen bezahlbaren Kunst-Intellis geht das erstaunlich schnell.

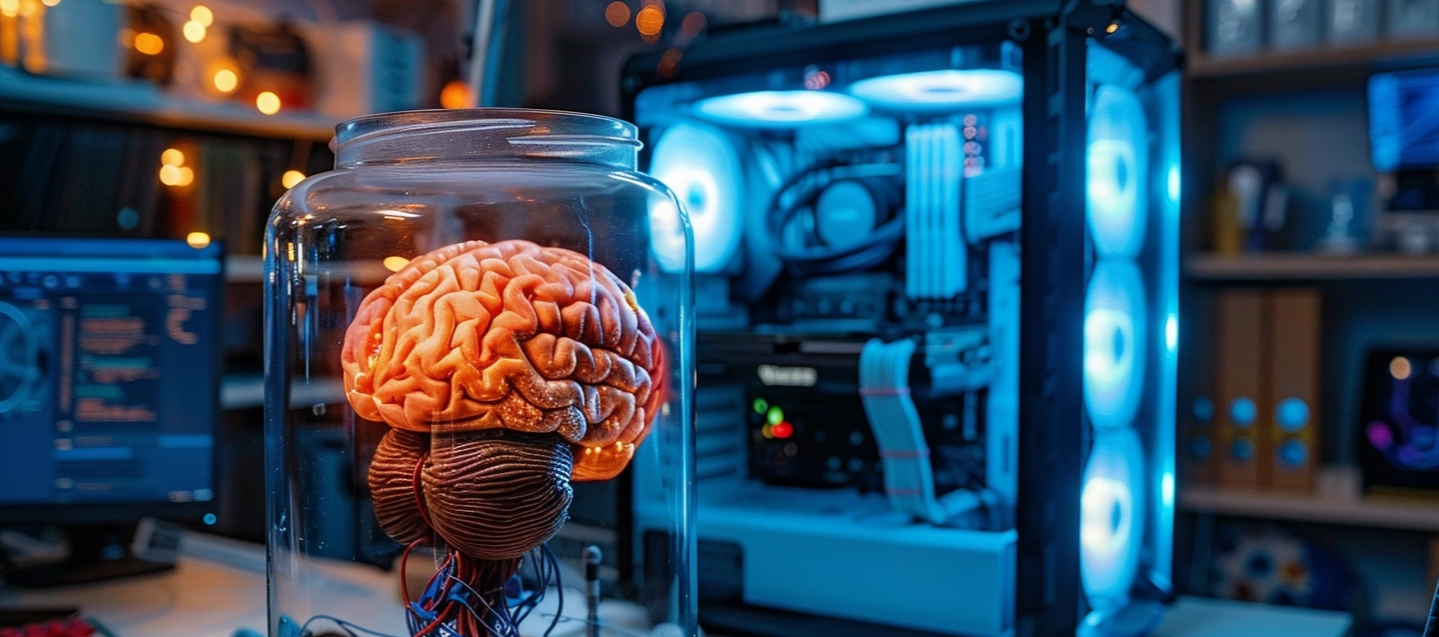

Hat es da überhaupt Sinn, auf der eigenen Hardware ein LLM oder anderes laufen zu lassen?

Der Wert von Offline-LLMs liegt in Folgendem:

- Ich lerne etwas

- Die lokale LLM-Instanz ist eine tolle Informationsquelle

- Das Internet ist ausgefallen? Kein Problem. Das Lama weiß fast alles und kann Fragen beantworten

- Meine Daten gehen nicht ins Netz

- private Bilder

- Texte und Informationen

- erzeugte Bilder

Und die Qualität?

| GPT 4.0 | llava:latest |

|---|---|

| write a funny haiku about spring and waiting for summer | |

| Spring teases with blooms, „I’ll be summer,“ it whispers— Sneezes say, „Not yet!“ | Spring has sprung, But I’m still waiting for summer, Bring on the heat! |

| kannst du das auf deutsch übersetzen? | |

| Frühling neckt mit Blüh’n, „Ich werd‘ Sommer,“ flüstert’s leis’— Niesen sagt, „Noch nicht!“ | Frühling hat angefangen, doch noch immer wart‘ ich auf Sommer, komm bald mit der Hitze! |

| kannst du das folgende Haiku auf deutsch übersetzen (vize versa) | |

| Frühling erwacht, Doch ich wart‘ auf den Sommer, Bring her die Hitze! | „Frühlings lacht und blüht, „Ich werde Sommer sein,“ sagt sie— Nasen hör’n auf den Schnee.“ |

Google Translate zum Vergleich: | „Frühling lacht mit Blumen, „Ich werde Sommer sein,“ weisset er— nichts als Schneezungen.“ |

| Der Frühling lockt mit Blüten, „Ich werde Sommer sein“, flüstert es – Nieser sagen: „Noch nicht!“ | „Frühling lacht mich an mit Blüten, „Ich werde Sommer sein“, flüstert es mir— Nasenflüge sagen, „Noch nicht!“ |

Übersetzen ist nicht leicht.

GPT hat das Bild links erstellt um sein Haiku darzustellen… Multimodalität ist cool. Das kann Llava nicht nicht.

Aber Lava kann das Bild „lesen“… und beschreiben, oder im kontext des Haiku interpretieren.

The image you’ve provided seems to relate to the haiku in several ways:

- Seasonal Imagery: The blooming flowers and the presence of birds allude to springtime, which is often associated with the beginning of a new season or cycle in nature. The spring-themed illustration could be seen as an embodiment of the „spring teases“ line from the haiku.

- Transition: The characters might represent the transition between seasons. One character seems to be embracing the arrival of summer, symbolizing warmth and growth that is associated with the summer season. The other character’s reaction could be interpreted as a reminder that spring is still in progress and that „summer“ has not yet fully arrived.

- Emotional Response: The characters‘ expressions and body language convey emotions similar to those described by the haiku. One character appears to be joyful, embodying the anticipation of summer, while the other character’s reaction suggests surprise or even a bit of discomfort, which could be seen as an emotional response to the arrival of spring, as suggested by the phrase „Sneezes say, ‚Not yet!’“

In summary, the image and the haiku both deal with the transition between seasons and the emotional responses that can come with those changes. The characters in the illustration seem to be embodying these themes through their expressions and interaction within the garden setting.

Und das ist was Midjourney mit dem Haiku tut:

und das macht es aus der Beschreibung des Haiku:

Auch das Lokal-Lama kann einen in eine Rabbit-Hole zerren…

Man sieht die Limitationen:

- Geschwindigkeit

- Sicherheit der Ausdrucksweise

- Deutsche Sprache

- Nur teilweise Multimodalität

Aber das sind die schlechtesten AIs die wir je sehen werden… Jede Generation wird mächtiger. Und je nach Hardware kann man zur Steigerung beitragen. Meine Grafikkarte hat „nur“ 8GB. Eine Headless Nvidia Tesla Karte mit 24GB oder eine RTX 4060 mit 64GB wären im Stande größere LLMs schneller zu verarbeiten.

Man darf träumen…

Und wir alle können die Frage beantworten die der Film Bladerunner aufwarf: Träumen Roboter von elektronischen Schafen?

Nein, sie halluzinieren LLamas!

![bitspirit[d]uality](http://www.bitspirits.com/wp-content/uploads/2023/06/header_bitspidu-1024x293.png)